R. Mothi, M. Mohan, M. Muthuvinayagam, C. Vigneshwaran, S. T. Lenin, M. Manohar y P. Ganesh

Este trabajo tomado del libro Deep Learning in Medical Image Analysis Recent Advances and Future Trends. 2025. Mostrando en este capítulo la importancia estratégica de los países asiáticos en este caso la INDIA, como se debe posicionar el sistema de salud para el siglo de la información, la big data y AI. Excelente análisis con ejemplos de aplicación ya utilizándose en el mundo real

3.1 INTRODUCCIÓN

India había reportado una población de 1.39 mil millones en enero de 2021; 624 millones eran usuarios de Internet en los 1.100 millones de conexiones móviles [1].

El desarrollo de la tecnología de la información en las últimas décadas ha permitido una revolución en las infraestructuras científicas, sanitarias y educativas. Las computadoras personales altamente configuradas, el ancho de banda máximo, los sistemas de redes inalámbricas y el uso de Internet aumentaron la conectividad en toda la población. Los sistemas de salud de la India tienen más obstáculos, especialmente en las zonas pobres y rurales. El país cuenta con muchos profesionales de la medicina: más de un millón de médicos y dos millones de profesionales de enfermería [2].

La proporción de disponibilidad de médicos en la India es de 2,2:1000, mientras que en China es de 2,8:1000 [3]. El sesenta por ciento de los hospitales indios están ubicados en ciudades que ocupan el 32% de su población. El actual sistema de comunicación sanitaria depende de las redes 4G para su conectividad, pero el sistema sanitario inteligente basado en 5G ofrece enormes servicios con el máximo ancho de banda, alta fiabilidad, latencia y entrega de datos [4]. Los servicios de red 5G comprenden URLLC (comunicaciones ultra confiables de baja latencia), eMBB (banda ancha móvil mejorada) y mMTC (comunicaciones masivas de tipo máquina). Entre estos, mMTC proporciona una alta conectividad a Internet; eMBB facilita el servicio de videollamadas, perspectivas de telemedicina, diagnóstico, tratamiento y realidad aumentada / realidad virtual (AR/VR); y URLLC es responsable de los drones y los vehículos automatizados para apoyar la vigilancia [5].

La Organización Mundial de la Salud (OMS) define un Sistema de Salud Sostenible como un sistema que mejora, mantiene o restaura la salud, minimizando los impactos negativos en el medio ambiente y aprovechando las oportunidades para restaurarlo y mejorarlo, en beneficio de la salud y el bienestar de las generaciones actuales y futuras. [6]

Este capítulo consolida la importancia y el requisito actual del aprendizaje profundo en la interpretación de señales de electrocardiograma (ECG), la aplicación de LabVIEW y la transformada de ondículas discretas (DWT), los hallazgos patológicos digitales y el análisis proteómico para encontrar una solución para la condición patológica a través del análisis de vías. Esto ayudará a los investigadores a resolver los problemas de salud actuales con un enfoque holístico.

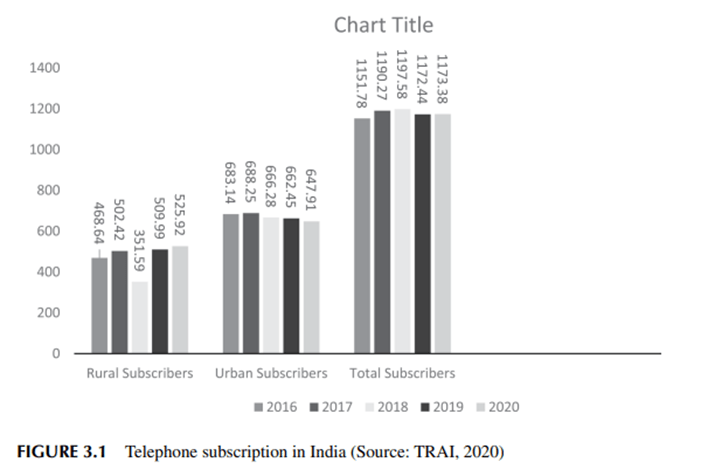

3.1.1 Sistema de salud impulsado por la tecnología: escenario indio

El gasto en investigación y desarrollo en la India registró un 76% para varios sectores prioritarios, como la salud, las industrias de defensa, la agricultura, la silvicultura y la pesca, las industrias, el espacio, el transporte, las telecomunicaciones y el desarrollo de infraestructuras. De estos, el 18,6% del gasto se utiliza para los sectores de la salud y el 8,7% para el transporte, las telecomunicaciones y el desarrollo de infraestructura [7]. Se requiere una transición positiva en el sistema de salud indio para satisfacer los requisitos de la industria de la salud masiva. Gestiona la instalación de infraestructuras en el entorno hospitalario, reduce el tiempo de consulta y extiende el servicio a todos los rincones del país. Casi el 75% de la población india reside fuera del entorno urbano y tiene acceso a hospitales limitados. Los principales objetivos de la Política Nacional de Comunicaciones 2018 incluyen 1) garantizar la banda ancha para todos, 2) la creación de cuatro millones de oportunidades de trabajo en el área de la comunicación digital, 3) el aumento del PIB del 6% al 8%, 4) colocar a la India entre los cincuenta primeros países en el Índice de Desarrollo de las TIC documentado en todo el mundo, 5) promover la contribución de nuestro país a las cadenas de valor globales, y 6) garantizar la soberanía digital [8]. Nuestro país se coloca en el papel de liderazgo en la fijación de fibra óptica a través de las cuentas del área rural, que es de casi 600,000 aldeas con la bandera de BharatNet. Esta iniciativa utiliza la nube, la tecnología 5G, el análisis de datos y el IoT para preparar la tecnología digital, y crea más oportunidades para competir en la cuarta revolución industrial. La suscripción telefónica en diciembre de 2019 se reportó en 1,172.44 millones, mientras que en diciembre de 2020 fue de 1,173.83 millones. El total de usuarios de Internet aumentó de 718,74 a 795,18 millones. La figura 3.1 muestra las suscripciones telefónicas en la India para los años 2016 a 2020 [9]. Las tecnologías de acceso de próxima generación (NGAT) permiten a los proveedores con licencia de conectividad a Internet garantizar la reducción de costos, brindar un servicio de alta calidad y maximizar los ingresos. El objetivo principal de la red de próxima generación (NGN) es acceder a la gama comprendida entre 3 GHz y 4 GHz. La NGN utiliza redes de espectro de alta capacidad con banda E que oscila entre 71-76 y 81-86 GHz y banda V con un alcance de 57-64 GHz.

3.1.2 Biotecnología y asistencia sanitaria Después de cincuenta años de elucidación de la estructura del ADN, se logró la finalización del proyecto del genoma humano.

En 2017, el costo total de la secuenciación fue de 2.700 millones de dólares, mientras que el costo fue de solo 100 dólares para la secuenciación del genoma completo utilizando la máquina de secuenciación de próxima generación de Illumina. La evolución de la medicina molecular fue muy esperada durante el período para explicar la arquitectura de los genes, las transcripciones, las proteínas y los procesos metabólicos. Los procesos celulares y moleculares mejoraron el cribado de biomarcadores, dirigieron el diseño de fármacos específicos y proporcionaron métodos de diagnóstico bien definidos para maximizar la monitorización del sistema sanitario.

La inteligencia artificial y el diseño de fármacos basados en sistemas crearon muchas oportunidades para encontrar nuevos candidatos a fármacos en un corto periodo de tiempo. Las nuevas moléculas de fármacos habilitadas por la IA dieron lugar a nuevas soluciones terapéuticas para la actual situación de pandemia de COVID-19. Se utilizó software computacional para interpretar las consultas de datos bioinformáticos. Las herramientas bioinformáticas están involucradas en la minería de datos y el análisis de diversos datos ómicos [10]. La fisiología humana es de naturaleza muy compleja y requiere un enfoque biológico integrador para encontrar soluciones. HumMod se basa en un modelo matemático y utiliza simulaciones apropiadas que trabajan para 5000 factores variables diferentes, incluido el sistema cardiovascular; sistema respiratorio, neural, nefrológico; sistema muscular; y vías metabólicas. Este modelo matemático se deriva de datos empíricos obtenidos de la literatura revisada por pares. El análisis de datos se ejecuta mediante el lenguaje de marcado extensible (XML) y se genera como simulaciones que describen la fisiología de los seres humanos. El navegador del modelo matemático para el análisis fisiológico se muestra en la Figura 3.2. La precisión del modelo amplía los cambios cuantitativos y cualitativos observados durante los ensayos clínicos [11]. Los datos disponibles en varias bases de datos se pueden utilizar para realizar análisis a través de métodos de aprendizaje supervisado y no supervisado. La significación estadística de las proteínas se identificó con el servicio de herramientas revisadas por pares como MetaboAnalyst 5.0 [12] y Reactome [13]. Mediante el uso de la herramienta, podemos encontrar moléculas de proteínas estadísticamente probadas y su análisis de rutas metabólicas. Atiende a PCA (análisis de componentes principales), PLS-DA (análisis discriminante de mínimos cuadrados parciales) y FCA (análisis de cambio de pliegue), y representa gráficamente mapas de calor y gráficos de volcanes. Los resultados registrados en las herramientas cuando utilizamos los datos secundarios nos permiten continuar con la investigación en el campo de la proteómica del cáncer.

3.1.3 Aprendizaje automático y atención médica

La atención sanitaria inteligente está mediada por la IA, el aprendizaje automático y el Internet de las cosas saludables (IoHT), lo que permite la prevención de enfermedades, el diagnóstico preciso de diferentes dolencias y el tratamiento adecuado. El aprendizaje automático representa un enfoque artificial de vanguardia para establecer vías de medicación personalizadas. El apoyo a la toma de decisiones clínicas vinculado a la inteligencia artificial se facilita a través del aprendizaje automático (ML). Las técnicas de ML se centran especialmente en las historias clínicas electrónicas y el reconocimiento oportuno de datos, lo que pone de manifiesto su importancia en este ámbito. La gran cantidad de datos que se mantienen para cada paciente es manejada por muchos algoritmos de ML exitosos. El ML puede estar involucrado en muchas áreas del sistema de atención médica, lo que incluye la clasificación del paciente en función de sus enfermedades, la recomendación de posibles tratamientos, la agrupación de grupos similares de pacientes y la predicción de posibles resultados. El ML puede servir a la automatización en el sistema de gestión del hospital. El sistema de salud basado en inteligencia artificial incluye confiabilidad, explicabilidad, usabilidad y transparencia [14].

3.1.4 Aprendizaje automático para patología

La mayoría de las aplicaciones de la inteligencia artificial en patología se encuentran todavía en una fase rudimentaria. Solo un número limitado de dispositivos médicos aprobados por la Administración de Alimentos y Medicamentos (FDA, por sus siglas en inglés) son compatibles con la inteligencia artificial y ayudan en la clasificación de células sanguíneas/fluidas y en la detección de citología cervical. El aprendizaje automático (ML) se utiliza en entornos de investigación para la clasificación y el diagnóstico del cáncer de pulmón [15, 16], la clasificación de pólipos del área colorrectal [17], el diagnóstico y la categorización del linfoma [18] y la medición del crecimiento del tumor de mama [19], así como para encontrar metástasis en los ganglios linfáticos [20–22], analizar la recurrencia del cáncer de vejiga [22], identificar el estroma tumoral [23], y estimar el pronóstico en cánceres de pulmón y cerebro [24, 25]. Se realizó una revisión de las aplicaciones del aprendizaje automático en patología [26]. Se observó una aplicación de aprendizaje automático, en Chameleon [27, 28], que comparó el funcionamiento de los algoritmos utilizados por muchos equipos de investigación. La genética y el pronóstico de las células cancerosas utilizando secciones histológicas para encontrar inclusiones linfocíticas se pueden llevar a cabo de forma automática [29, 30]. Se puede identificar el área de interés y el contenido de la diapositiva [31, 32]. Se han desarrollado varios algoritmos de aprendizaje automático para diagnosticar condiciones patológicas, incluido el análisis de las características morfológicas de las células cancerosas, la división celular y los patrones del núcleo, los vasos sanguíneos y la condición del flujo sanguíneo en los conductos. El aprendizaje automático también se ha aplicado al análisis del riesgo cardíaco [33], al diagnóstico clínico de la enfermedad hepática y la anemia [34], al diagnóstico del sistema endocrino [35] y a muchos otros trastornos específicos [36]. El aprendizaje automático permite la comparación de los resultados existentes con los resultados de las pruebas [37], lo que facilita la autovalidación de los estudios de GC-MS y elimina potencialmente la necesidad de realizar pruebas [38]. Hoy en día, la detección artificial está aumentando y se utiliza en una variedad de subespecializaciones con distintos tipos de muestra [39]. Según los primeros estudios sobre la precisión, los sistemas basados en IA muestran la capacidad de identificar datos precisos [40], lo que marca un hito para la adopción de hallazgos patológicos en un enfoque computacional [41]. Se clasificaron tres tipos de cáncer, cáncer de próstata, carcinoma de células y cáncer de mama, con 44732 imágenes de las láminas validadas mediante el método de redes neuronales profundas. Encontraron la precisión de cinco veces el aumento de imágenes de diapositivas completas. Para cada tipo de tejido, adoptaron un modelo estadístico basado en ML para la clasificación de los diferentes tipos de cáncer. Observaron el área bajo la curva (AUC) por encima de 0,98 cuando se usa clínicamente, lo que permite a los patólogos eliminar el 65-75% de los portaobjetos del estudio durante el mantenimiento del 100% de la sensibilidad [42]. Wildeboer et al. presentaron algoritmos de aprendizaje profundo relacionados con diversos métodos de imagen como la TC (tomografía computarizada), la EUI (ecogenicidad en imágenes de ultrasonido) y la resonancia magnética (RM) como una metodología asistida por computadora para el diagnóstico del cáncer de próstata [43].

Los siguientes pólipos colorrectales, a saber, 1) hiperplásicos (HP), 2) sésiles serrados (SS), 3) dentados tradicionales (TS), 4) tubulares (T) y 5) pólipos vellosivos (VP) se pueden identificar con precisión utilizando una variedad de técnicas de aprendizaje profundo desarrolladas por Korbar et al. De las 2074 imágenes, el 90 % de las imágenes se utilizaron para los datos del modelo de entrenamiento y el 10 % de las imágenes se consignaron para su validación.

La precisión para la clasificación de los pólipos colorrectales reportó un valor de intervalo de confianza (IC) del 93% entre 89-96% [44]. Las redes neuronales recurrentes (RNN) y las redes neuronales convolucionales (CNN) combinadas se diseñaron para predecir el resultado en función de muestras de microarrays de tejido obtenidas de 420 pacientes con cáncer colorrectal [45].

De acuerdo con los hallazgos, el cociente de riesgo para la predicción del resultado basada en la red neuronal profunda (DNN) fue de 2,3 (intervalo de confianza: 1,79-3,03), y el AUC fue de 0,69. Wang et al. lograron el CAMELYON16 y utilizaron los parches de entrada con 256 x 256 píxeles de la parte negativa y positiva de las imágenes de los ganglios linfáticos para entrenar diferentes tipos de modelos como AlexNet, GoogLeNet, FaceNet y VGG16. GoogLeNet tiene el mejor rendimiento y, por lo general, es estable y más rápido entre los distintos algoritmos. Utilizando el sistema de aprendizaje profundo (DL), la precisión del diagnóstico observada por los patólogos mejoró significativamente ya que el área bajo la curva (AUC) aumentó del valor de 0,966 a 0,995, y representa la reducción del 85% del error humano [46].

La telemedicina (TM) y la medicina asistida por ordenador (CAM) se están extendiendo rápidamente por el mercado durante el brote de COVID-19. La condición y el riesgo máximos de contagio en el aislamiento sistémico y social trajeron desafíos inesperados para las prácticas médicas tradicionales. La aplicación de la inteligencia artificial en la medicina asistida por ordenador, junto con los datos clínicos de las historias clínicas electrónicas (HCE), permite identificar los factores de riesgo que afectan a la población. Este enfoque permite una gestión proactiva de los problemas de salud pública, al tiempo que se mantienen altos estándares de calidad y seguridad [47].

3.2 ESTUDIOS PROTEÓMICOS

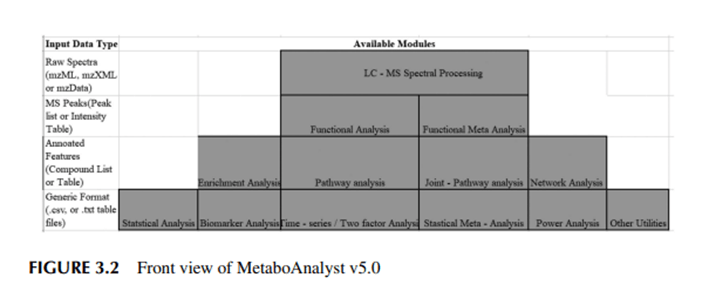

3.2.1 MetaboAnalyst v5.0 El procesamiento de datos de proteómica, la visualización, el análisis estadístico y la extracción de proteínas resaltantes para su posterior análisis se realizan en MetaboAnalyst, una herramienta basada en la web. La herramienta se emplea en el análisis de estadísticas, vías de enriquecimiento y picos de espectrometría de masas para la vía. La carga de datos se llevó a cabo en MetaboAnalyst utilizando archivos de valores separados por comas (CSV). El fichero comprende datos de control y experimentales. Los datos cargados pueden ser analizados por la herramienta según el requisito. Los datos proteómicos pueden ser curados y normalizados para obtener significación estadística, y la normalización es un paso importante en el análisis proteómico [48]. Los factores clave considerados durante la normalización incluyen las diferencias observadas en la magnitud de la concentración de la muestra, los cambios en el pliegue y las características técnicas [49]. MetaboAnalyst v5.0, una herramienta fácil de usar contiene imágenes descargables del análisis estadístico. Tiene datos analíticos asequibles como el análisis paramétrico y no paramétrico univariante, el análisis de datos multivariado supervisado y no supervisado, y el análisis de correlación paramétrico y no paramétrico [50]. La figura 3.3 muestra la vista frontal de la herramienta MetaboAnalyst v5.0. Se puede realizar un análisis supervisado mediante análisis discriminante de mínimos cuadrados parciales (PLS-DA) y análisis multivariado no supervisado realizado empleando PCA (análisis de componentes principales). El PCA se puede calcular mediante el uso de una matriz de covarianza de datos, y PLS-DA se basa en una regresión lineal múltiple que permite encontrar la covarianza al máximo [51].

3.2.2 Reactome

Reactome es una herramienta en línea utilizada para encontrar posibles vías utilizando los datos obtenidos de MetaboAnalyst v5.0 (www.reactome.org). La herramienta funciona con el archivo CSV y genera un informe en PDF. Las vías generadas en Reactme se pueden estudiar para

Comprender las vías biológicas. La interacción proteína-proteína y el hallazgo de biomarcadores mediados por espectroscopia de masas se pueden llevar a cabo mediante el uso de Reactome [52]. Esta herramienta proporciona datos relacionados con los genes y las proteínas en función de su ID. Uniprot, GeneBank, OMIM, EMBL y muchas otras bases de datos admiten la herramienta Reactoma. En la Figura 3.3 se indican los posibles métodos de análisis disponibles en la herramienta Reactoma.

3.3 SISTEMA DE MONITORIZACIÓN DE LA SALUD MEDIANTE DEEP LEARNING

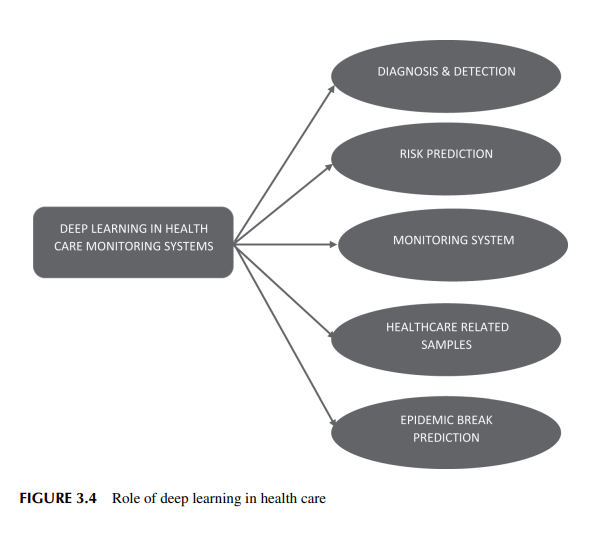

El aprendizaje profundo, un método de aprendizaje automático, es crucial para el análisis de datos, que también implica modelos estadísticos y analíticos de datos. Recopilar y analizar una gran cantidad de datos es beneficioso para el análisis de datos. Este método se utilizará para pronosticar datos estructurados y no estructurados empleados en modelos matemáticos que están diseñados para funcionar como el cerebro humano. El aprendizaje profundo se ha empleado en todos los aspectos de la vida humana, y los datos relacionados con la salud son cada vez más importantes para descubrir grandes facilidades para los registros de salud de los pacientes y para reconocer los síntomas de la enfermedad. La figura 3.4 muestra el papel del aprendizaje profundo en la atención sanitaria. 3.3.1 Sistema sanitario avanzado En los próximos años, el sistema sanitario será testigo de nuevos avances en las técnicas de aprendizaje profundo, mejorando los sistemas de toma de decisiones clínicas. Tecnología

puede ayudar a los profesionales médicos mejorando las capacidades de las herramientas integradas basadas en la tecnología de IA que implementan y analizan fácilmente datos complejos y mejoran los métodos de diagnóstico temprano para reducir la tasa de mortalidad y aumentar la precisión de las predicciones de enfermedades en este escenario. Para proporcionar apoyo clínico adicional, las condiciones inconscientes se diagnostican inmediatamente y se convierten en una prioridad para los pacientes gracias a la estrecha comunicación entre los profesionales médicos y su entorno. El aprendizaje profundo o las redes neuronales tienen muchas características y niveles de variables que son los tipos más cruciales de aprendizaje automático. Prevén resultados. Más allá de lo que el cuerpo humano puede reconocer, el aprendizaje profundo puede impulsar la detección de elementos clínicamente relevantes en los datos. El aprendizaje profundo y las redes neuronales trabajan juntos para lograr un mayor nivel de precisión diagnóstica que la generación anterior de herramientas de automatización y detección analítica (Figura 3.5).

3.3.2 Procesamiento del lenguaje natural

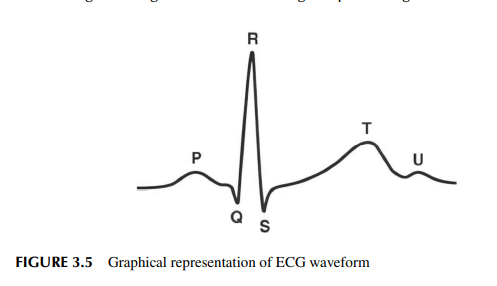

El procesamiento del lenguaje natural, el modelado estadístico y el reconocimiento de voz son tres áreas principales en las que el aprendizaje profundo se utiliza cada vez más. La creación, comprensión y clasificación de información sanitaria es una de las aplicaciones del dominio de la PNL. Las máquinas pueden identificar y clasificar los datos de los pacientes para su uso en la elaboración de informes de salud, la interacción con los pacientes y la celebración de debates mediante sistemas de aprendizaje profundo. En los sistemas sanitarios, el NLP es un método para extraer información de datos no estructurados. El NLP se ha aplicado para procesar datos clínicos no estructurados o no cuantitativos en la industria médica para clasificar o predecir los registros de salud de los pacientes a través de la extracción de la transformación de la información y los datos basados en resultados [53]. 3.3.3 Electrocardiograma (ECG) La enfermedad causada por el corazón se investiga mediante el pulso eléctrico registrado desde el corazón y se denomina electrocardiograma (ECG). Los impulsos obtenidos de esos impulsos eléctricos se registran en términos de ondas como PQRST, como se muestra en la Figura 3.5. Las células presentes en el corazón se conocen como células cardíacas; Están rodeados y llenos de solución. En comparación con la membrana celular externa,

Todas las membranas celulares presentes en el interior están cargadas negativamente en el momento de la posición de reposo. La célula cardíaca interna se carga positivamente con la de la membrana externa solo cuando el corazón se inicia con un pulso eléctrico. El cambio de polaridad en la membrana celular se debe a los pulsos eléctricos, y el cambio de polaridad se denomina despolarización. La célula cardíaca estimulada vuelve a la condición de reposo una vez que ocurre la despolarización, y se llama repolarización [54].

3.3.3.1 Análisis de la señal del ECG

El ECG es una herramienta para analizar e identificar los ritmos anormales del corazón, y con la ayuda de la señal del ECG se puede encontrar fácilmente la enfermedad causada por el corazón. Las señales de ECG se expresan mediante pulsos aislados o pulsos aislados con una secuencia cuasiperiódica en la naturaleza. Debido a la deriva de la línea de base, las interferencias de la línea eléctrica y los ruidos, el análisis de la señal de ECG resulta en complicaciones. Estas perturbaciones pueden influir en la interpretación visual de la señal con la de los resultados obtenidos por el análisis fuera de línea basado en ordenador. Para filtrar la deriva de referencia disponible en la señal de ECG, se puede utilizar un filtro de fase lineal de paso alto, pero se puede evitar el uso de un filtro no lineal, lo que da lugar a la introducción de distorsiones en la señal de ECG filtrada. La deriva basal se utiliza principalmente en los cambios de forma de onda PQRST e influye en el diagnóstico preciso de las enfermedades cardíacas. La frecuencia cardíaca instantánea [55] se puede calcular con la ayuda de la onda R, y se detecta mediante la detección de pendiente en la onda R. El análisis de la señal del ECG por computadora es necesario para encontrar rápidamente la enfermedad causada por el corazón. En este sentido, la señal puede analizarse utilizando MATLAB,® LabVIEW y muchas otras herramientas.

3.3.3.2 Análisis de señales de ECG basado en LabVIEW

El paciente afectado por un problema cardíaco necesita ser monitoreado regularmente. Si el paciente se encuentra en un área remota y se tarda mucho en llegar al hospital, el paciente puede ser monitoreado desde su casa con cualquier sistema de monitoreo para verificar y analizar el estado del paciente en intervalos regulares de tiempo. El sistema se utilizará para monitorear las actividades cardíacas y enviar los resultados obtenidos a los médicos por correo. El objetivo es monitorizar al paciente utilizando un diseño de bajo coste y una implementación eficaz de un sistema de monitorización de ECG desde el entorno no clínico con el médico sentado en su cámara. La señal de ECG obtenida del sistema de monitoreo puede extraer los parámetros como la amplitud y el período de las formas de onda PQRST a analizar. Además, con la ayuda de un sistema basado en GUI (LabVIEW), se pueden mostrar para el monitoreo [56]. Las señales de ECG se adquieren a través de los terminales de salida de los sensores. Los datos de los sensores se adquieren a la herramienta LabVIEW con la ayuda del sistema DAQ conectado, y los datos se almacenan en formato de archivo NITDMS para el análisis fuera de línea. Los datos de ECG recopilados de los electrodos se procesan en el LabVIEW y se utilizan para el diagnóstico adecuado del paciente en comparación con los valores normales de las señales de ECG como se indica en la Tabla 3.1 [57]. Inicialmente, los datos del paciente se recopilan utilizando el panel frontal (Figuras 3.6-3.9) diseñado en LabVIEW, y los datos recopilados por el panel frontal se procesan

en el diagrama de circuito creado en el panel posterior; se utiliza para procesar los datos recopilados [58]. Los datos tanto de los pacientes como del médico ya están almacenados en el directorio de archivos y se inicializan. El panel frontal se utiliza para mostrar los detalles del médico y del paciente desde el archivo y se muestra en sus respectivas columnas. Una vez iniciados, los controles e indicadores se establecen en los valores predeterminados. Para monitorear el rango de electrodos que cae desde el valor mínimo y máximo que se ha generado el código, y una vez que el valor del electrodo de un paciente supera un cierto valor o cae por debajo del promedio del rango dado, el historial del paciente pasa automáticamente a estado crítico. Los valores de los electrodos se almacenan en una hoja de Excel para su posterior procesamiento. Los valores de los electrodos en la hoja de Excel se envían al médico por correo si es necesario.

3.4 ESTRATEGIA DE DIAGNÓSTICO MÉDICO MEDIANTE EL USO DE LA TECNOLOGÍA DE LA COMUNICACIÓN

En la actualidad, el sistema de salud da lugar a una declaración abierta sobre la atención médica, los métodos de tratamiento, la naturaleza de las complicaciones de salud y es pionero en la investigación biomédica para el mejoramiento de los seres humanos. Los amplios impactos de la COVID-19 han llevado al mundo a concentrarse en los dispositivos que funcionan digitalmente y a pasar al desarrollo más integrado de productos. Las tecnologías digitales en el sistema sanitario proporcionan la máxima accesibilidad y flexibilidad [59]. Los avances observados en los datos de IA se registran a partir de pacientes que hacen uso de dispositivos portátiles y teléfonos inteligentes con la presencia de las plataformas de Google, las redes de Apple y Amazon [60]. Esto aumenta la comunicación entre los pacientes y los expertos en atención médica. Hoy en día, los hospitales son más dependientes de las TIC, lo que disminuye la brecha entre los sectores urbano y rural [61].

3.4.1 Análisis de señales de ECG mediante transformada de ondículas en MATLAB El análisis de señales de ECG se vuelve más difícil debido a la variación de los factores morfológicos en la forma de onda en grandes cantidades, no solo con diferentes pacientes, sino también con el mismo paciente en diferentes intervalos de tiempo. En el análisis, las formas de onda de ECG resultantes son diferentes para el mismo paciente y son las mismas para diferentes tipos de latidos. La transformada se utiliza principalmente en una transformada basada en ondículas, que se utiliza para eliminar el ruido y detectar las tendencias entre las señales, los puntos de ruptura y la discontinuidad de las derivadas superiores en las señales [62, 63]. Aquí, la ondícula db4 se utiliza en la señal de ECG para la detección de impulso y su discontinuidad de elementos de frecuencia. La señal de impulso aquí se genera artificialmente con los datos predefinidos de la señal de ECG para nuestros fines de análisis [64]. La ondícula db4 se utiliza para el análisis de la señal en el dominio de la frecuencia. Aquí se aplica la descomposición de tercer nivel a la señal. La eliminación de ruido de la señal se logra mediante DWT, y se puede realizar mediante la descomposición de la señal a un cierto nivel y aplicando el umbral a los coeficientes DWT obtenidos y finalmente reconstruyendo la señal a su señal original. Se llevan a cabo tres procedimientos para eliminar el ruido de la señal; Inicialmente, el método de análisis de ondículas se aplica a una señal ruidosa con nivel N, luego se aplica un umbral en cada coeficiente desde el nivel 1 hasta el nivel N, y finalmente la señal se sintetiza con la ayuda de coeficientes de detalle alterados con un nivel de 1 a N y coeficientes de aproximación de N par. No es posible eliminar señales ruidosas con corrupción. Calculamos el valor del umbral global para todos los niveles de la siguiente manera:

Donde la desviación estándar de los coeficientes DWT se expresa como σ y también el número de píxeles o muestras de la señal procesada se expresa como L y los valores umbral se estiman utilizando la herramienta MATLAB. La señal de ECG se descompone hasta el tercer nivel convolucionándola con un filtro db2, lo que implica un muestreo descendente por un factor de 2. Este proceso extrae tanto el detalle como los coeficientes aproximados. Normalmente, la aproximación y los coeficientes detallados se obtienen mediante un filtro de paso bajo y paso alto g(.) en cada nivel y se descomponen aún más para el siguiente nivel. El análisis de la señal de HRV (variabilidad de la frecuencia cardíaca) con diferentes resoluciones se lleva a cabo en la descomposición con función elemental tanto en el dominio del tiempo como en el de la frecuencia. Estas funciones elementales se denominan ondículas. Se realizó una descomposición multinivel de la señal IHR (frecuencia cardíaca instantánea) mediante DWT. Aunque los componentes de frecuencia más baja de la señal IHR se utilizan para el análisis de la modulación a largo plazo en el SNA (sistema nervioso automático), esto conduce a un efecto en los espectros de potencia de las señales de HRV. Utilizamos el método de transformación wavelet para eliminar la tendencia de la señal IHR. El método propuesto aquí puede detectar transitorios y artefactos en la señal. Proporciona un análisis de múltiples resoluciones. Dado que el comportamiento del SNA se puede rastrear utilizando DWT [65], esta técnica mejora la comprensión de cómo interactuar con la actividad cardiovascular mediante sistemas de control automático. Dado que la técnica de ondículas proporciona una mejor resolución de tiempo-frecuencia, también podemos aplicarla al reconocimiento de patrones de ECG.

3.4.2 Monitoreo y análisis de señales de electrocardiograma usando LabVIEW El ECG es aquel en el que se genera la señal ya que se debe al parámetro eléctrico presente en la función del corazón, y es registrada por la herramienta y transmite información útil cuando ocurre un cambio en las ondas PQRST. El análisis de la señal de ECG se usa ampliamente para diagnosticar enfermedades que ocurrieron en el corazón, especialmente ataques cardíacos. En este capítulo, se analiza la función del corazón mediante el cálculo de la frecuencia cardíaca con intervalos (P, Q, R, S y t) mientras se utilizan señales de ECG. Los pacientes, especialmente aquellos que sufren de problemas cardíacos, necesitan tener chequeos regulares y de rutina para monitorear sus actividades cardíacas. Durante una emergencia, si un paciente requiere primeros auxilios y necesita ser trasladado de urgencia al hospital, pero no hay instalaciones disponibles o el hospital está ubicado en un área remota, puede hacer que el paciente se sienta incómodo y representar un riesgo para su vida. En esta situación, será necesario un sistema de seguimiento para controlar el estado de salud, especialmente la enfermedad relacionada con el corazón, y actualizar al médico por correo electrónico o cualquier otro modo. El correo recibido por el médico actúa como una herramienta para sugerir al paciente cuándo tomar las medidas de seguridad necesarias y qué primeros auxilios se deben realizar. Este trabajo se concentra en la implementación de un sistema de monitorización de ECG de bajo coste y eficaz para la monitorización frecuente de la actividad cardíaca del paciente en cualquier momento desde cualquier lugar, y el médico puede tratar al paciente desde el lugar donde se encuentre. Los parámetros del ECG, como el nivel de amplitud y el período de la onda PQRST, se adquieren y se muestran en la GUI de LabVIEW. Las señales de ECG observadas en el LabVIEW se dan en la Figura 3.6.

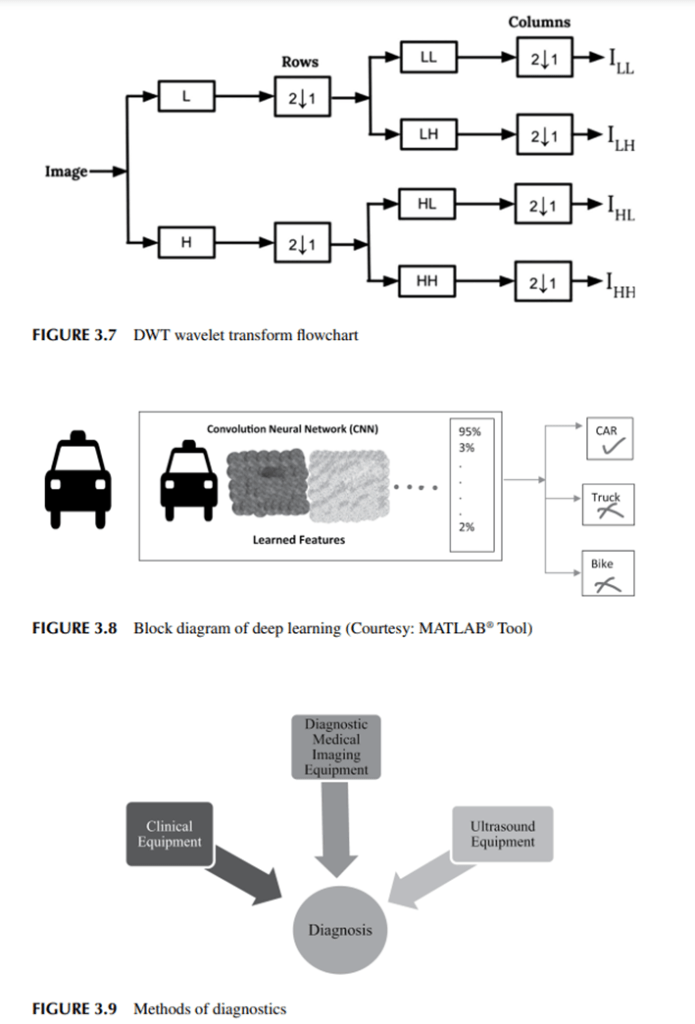

3.4.3 Compresión de imágenes biomédicas basada en la transformación de ondas La compresión de imágenes es importante en diversas aplicaciones, incluidos los campos comerciales, de investigación, defensa y medicina. La mayoría de los datos médicos se presentan en forma de datos multidimensionales, lo que constituye una gran cantidad en tamaño de datos, por lo que en este sentido se crea un sistema eficiente para procesar este tipo de datos para almacenarlos, recuperarlos, gestionarlos y transmitirlos. Por lo tanto, comprimir imágenes manteniendo la máxima calidad posible es muy importante para las aplicaciones del mundo real. El tamaño de los datos se puede reducir mediante la compresión de los datos médicos para que las capacidades de diagnóstico no se vean comprometidas. Para comprimir la imagen manteniendo la calidad de la imagen con menor tolerancia médica, se propone el sistema basado en DWT. Con esta técnica, se pueden reducir los ruidos como las motas, la sal y la pimienta en las imágenes de ultrasonido [66, 67]. Las imágenes se comprimen con énfasis en mantener la calidad en lugar de centrarse en disminuir el tamaño del archivo. La técnica de codificación de Huffman se aplica a los coeficientes cuantificados, y los bits obtenidos se utilizan para representar la imagen comprimida que se almacena y recupera siempre que se necesita. El algoritmo DWT es el más adecuado para una forma más eficiente de comprimir una imagen en una técnica sin pérdidas [68]. La Figura 3.7 describe el flujo de trabajo de transformación de ondículas. Como las ondículas se utilizan en esta compresión, todos los elementos de la imagen se comprimen conservando la calidad.

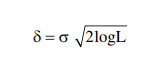

3.4.4 Aprendizaje profundo para imágenes cardíacas El aprendizaje profundo es un algoritmo que permite el estudio de la información, la estimación o predicción de acontecimientos futuros, la toma de decisiones o el uso del conjunto de datos (llamados datos de entrenamiento) que se utilizan para identificar patrones complejos. Una técnica de machine learning se convierte en una poderosa herramienta para la extracción de conocimiento útil y la toma de decisiones adecuadas a partir de big data. A medida que ha aumentado en los aspectos técnicos, el aprendizaje profundo apoya el aprendizaje automático y es un puente de conexión para la integración de grandes datos de maquinaria con el monitoreo inteligente del estado del mediador de máquinas. El aprendizaje profundo intenta modelar datos con representaciones de alto nivel y predice patrones mediante la organización de múltiples capas de información mediante arquitecturas jerárquicas. Hoy en día, el aprendizaje profundo se adopta en una variedad de aplicaciones como la bioinformática, la visión por computadora, el reconocimiento de audio y el reconocimiento automático de voz. Las arquitecturas de redes neuronales se utilizan ampliamente en algoritmos de aprendizaje profundo y utilizan más de 150 capas ocultas en lugar de las redes neuronales tradicionales. Las redes neuronales convolucionales (CNN) se utilizan principalmente como redes neuronales profundas, y los datos de entrada se convolucionan con características aprendidas, y los datos 2D se procesan utilizando capas convolucionales 2D. Con el uso de CNN, la señal de ECG se puede clasificar fácilmente para la detección y el diagnóstico de las señales. Está comprobado que el aprendizaje profundo es ampliamente utilizado para detectar ondas R para el análisis de la clasificación de arritmias en el ECG. El gran reto para los investigadores es la implementación de la técnica de aprendizaje profundo en señales de ECG. El aprendizaje profundo amplía la limitación en el acceso al conjunto de datos sin procesar y también necesita una gran capacitación y una plataforma específica para el proceso computacional. Las diferentes combinaciones de datos de entrada para el análisis de la señal de ECG fueron la señal bruta de ECG y los complejos QRS extraídos, junto con las características basadas en la entropía calculadas tanto en las señales brutas de ECG como en los complejos QRS extraídos. En los aspectos de investigación, las características normalmente basadas en la entropía con las redes neuronales desempeñan un papel importante en el análisis de las señales de ECG.

Se puede proponer que CNN utilice los complejos QRS extraídos y las características basadas en la entropía. Normalmente, la señal de 12 derivaciones se puede utilizar para la detección y estimación de la onda R utilizando el algoritmo de detección de onda R y el algoritmo K-mean. Con la ayuda de estos algoritmos, se puede generar la estimación de la posición del pico r.

3.5 APLICACIÓN DEL APRENDIZAJE AUTOMÁTICO PARA LA OBTENCIÓN DE IMÁGENES CARDÍACAS

Según los datos publicados por la OMS, las enfermedades cardiovasculares (ECV) son la principal causa de morbilidad y muerte a nivel mundial. En el año 2019, alrededor de 17,9 millones de personas perdieron la vida debido a las ECV, lo que representó el 32% de todas las muertes mundiales. La tasa de mortalidad se registró debido a infarto de miocardio y accidente cerebrovascular [69]. La tasa de mortalidad aumenta cada año. Los avances en la identificación de las ECV permiten una perfecta evaluación y tratamiento de las enfermedades cardiovasculares. Las técnicas de imagen médica como la tomografía computarizada, la resonancia magnética y los métodos de ultrasonido se utilizan ampliamente para conocer la anatomía de las estructuras cardíacas, sus patrones de movimiento y aspectos funcionales y para proporcionar apoyo al pronóstico, monitorear la enfermedad, diagnosticar y encontrar mejores opciones de terapia [69]. El uso de la inteligencia artificial, el aprendizaje profundo y el aprendizaje automático demostró ser una herramienta poderosa para interpretar y analizar imágenes médicas, identificar y predecir enfermedades y tratar enfermedades. La ecocardiografía sirve como la primera línea de diagnóstico por imágenes y, por lo general, actúa como una parte integral de la práctica médica cardíaca [70]. Muchas variables ecocardiográficas, junto con el seguimiento de manchas y el mapeo de flujo vectorial, han dificultado que los médicos evalúen los resultados [71]. El uso de una variedad de algoritmos con muchas modalidades ha crecido exponencialmente. Se empleó una CNN para evaluar los 14035 ECG durante un período de diez años [72]. Utilizando el método de ML de bosque aleatorio, Samad et al. predijeron la supervivencia después del ECG en una población de 171510 pacientes [73]. Motwani et al. investigaron el uso de un algoritmo de aprendizaje automático para pronosticar la mortalidad a cinco años en las tomografías computarizadas en comparación con las medidas cardíacas tradicionales para pacientes de 10030 con posible EAC [74]. Para predecir la muerte por todas las causas a cinco años, el algoritmo de aprendizaje automático mostró un AUC estadísticamente significativo más alto en comparación con la reserva de flujo fraccional. Un equipo de expertos predijo problemas cardiovasculares en 8844 pacientes utilizando un algoritmo de ML [75]. Existen algunos trabajos de investigación que exhiben la aplicación del aprendizaje automático. Bai et al. realizaron una red totalmente convolucional para examinar las imágenes de CMR [76]. Para evaluar la masa cardíaca y las métricas de función de varios conjuntos de datos, Winther et al. realizaron un sistema de aprendizaje automático de aprendizaje profundo para segmentar el ventrículo derecho, el ventrículo izquierdo y el epicardio [77].

3.6 RETOS DIAGNÓSTICOS EN APLICACIONES DEL SISTEMA SANITARIO

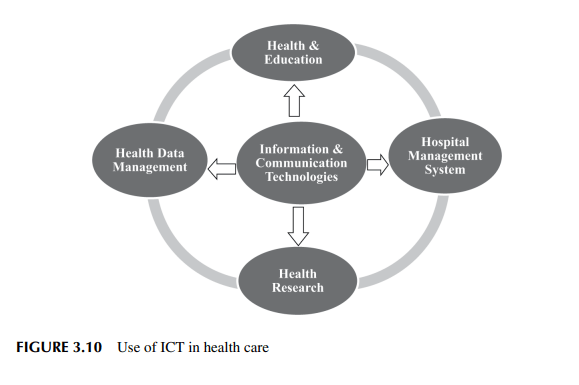

Hoy en día, el diagnóstico de un paciente por parte de un médico depende de equipos médicos asistidos: máquinas clínicas, de imágenes médicas y de ultrasonido. Además, el desarrollo de las TIC maximiza la naturaleza de la atención, amplía la seguridad del paciente y disminuye el gasto en aspectos laborales y regulatorios.

Los dispositivos TIC se hicieron fáciles de entender y son utilizados por una gran población en todo el mundo, reduciendo así la brecha de comunicación. En consecuencia, la apertura a los datos se ha vuelto sencilla utilizando las TIC, y las personas terminan más relajadas mientras hacen uso de los servicios de atención médica. El uso de las TIC en la atención sanitaria se puede clasificar en cuatro corrientes principales, como se muestra en la figura 3.10, como 1) Salud y educación, 2) Sistema de gestión hospitalaria, 3) Investigación en salud y 4) Gestión de datos sanitarios.

3.7 UNA POSIBLE SOLUCIÓN A LOS DESAFÍOS DE COMUNICACIÓN EN EL SISTEMA DE SALUD

La OMS definió la salud electrónica (eHealth) como «el uso rentable y seguro de las tecnologías de la información y las comunicaciones en apoyo de la salud y los campos relacionados con la salud, incluidos los servicios de atención médica, la vigilancia de la salud, la literatura sanitaria, la educación sanitaria, el conocimiento y la investigación» [78]. Los médicos pueden observar y predecir el sistema de tratamiento utilizando tecnología informática. Desde la reconstructiva relacionada con la cosmética hasta el cuidado dental, el modelado proporciona la solución adecuada a los pacientes. Muchos de los instrumentos médicos se incorporan con software y los resultados de las observaciones médicas se documentan correctamente. La tecnología láser y la administración de medicamentos involucraron una fuerza laboral más basada en sistemas. Las TIC dan apoyo al sistema sanitario de una manera notable. Otras áreas de las herramientas de TIC involucradas en el sistema de salud incluyen registros electrónicos del sistema médico y de salud, tarjetas de salud de pacientes, teléfonos móviles y tecnología vinculada a sensores para monitorear el sistema de salud, y redes educativas y de salud basadas en IoT. Se espera que la demanda supere los 100.000 millones de conexiones en diez años. En los últimos años se ha producido una gran escasez de datos que pueden ser satisfechas por las redes de quinta generación, y se considera que son ultrarrápidas, fiables, con alta capacidad de transmisión y baja latencia. Esta instalación está provista de 5G y conduce a la Worldwide Wireless Web (WWWW) [79].

3.8 CONCLUSIÓN La atención de la salud en la comunidad mundial está experimentando cambios profundos e inimaginables a nivel de base. La coordinación y consolidación de la tecnología al público es fundamental para conocer los patrones de desarrollo y uso adecuado por parte de la población. Hoy en día, casi todos los campos se mezclan con el diagnóstico, la documentación y el intercambio de conocimientos totalmente informáticos. En este documento se aborda el posible intercambio de nuevas tecnologías que permite comprender las necesidades de la sociedad de la mano de expertos de diversas disciplinas. Un enfoque holístico en el campo del sistema de salud es proporcionar puntos importantes de toma de decisiones para cumplir con el requisito actual en el resultado específico del