Preservación de las habilidades clínicas en la era de la asistencia con IA

Tyler M Berzin, Eric J Topol

Center for Advanced Endoscopy, Beth Israel Deaconess Medical Center and Harvard Medical School, Boston, MA 02215, USA (TMB); Scripps Research Translational Institute, La Jolla, CA, USA (EJT) tberzin@bidmc.harvard.edu

Resumen: El artículo analiza el impacto de la inteligencia artificial (IA) en la preservación de habilidades clínicas básicas, advirtiendo sobre el riesgo de la pérdida de habilidades y pérdida de competencia cuando los profesionales dependen excesivamente de la asistencia algorítmica. Se presentan evidencias de disminución del rendimiento clínico tras el uso rutinario de IA, especialmente en la detección de pólipos durante colonoscopias, aunque se reconoce que este efecto no es inevitable y puede variar entre individuos.

El texto propone estrategias inspiradas en otras industrias, como la aviación o la energía nuclear, donde la práctica deliberada y la exposición a situaciones sin automatización ayudan a mitigar la erosión de habilidades. Asimismo, sugiere la implementación de pausas intencionales en el uso de IA y la delimitación de tareas para mantener el pensamiento crítico, la vigilancia y la competencia clínica, especialmente durante la formación médica.

Finalmente, se destaca la importancia de que los clínicos sean capaces de evaluar la fiabilidad de las herramientas de IA, recibiendo los avances tecnológicos con cautela y atención a los cambios en la práctica profesional.

¿Cómo pueden los clínicos preservar las habilidades clínicas básicas en una era de asistencia algorítmica?

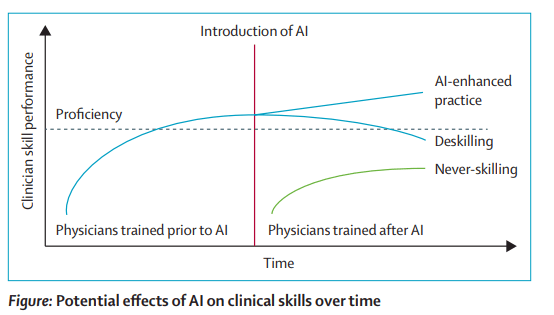

A medida que la inteligencia artificial (IA) asume un papel cada vez mayor en la práctica clínica, crece la preocupación de que la descarga de tareas clínicas y razonamientos conduzca a la pérdida de habilidades (deshabilidad), a la adopción de errores o sesgos de la IA (matar), o a la falta de competencia (nunca habilidad; cifra). Se ha observado evidencia de esta pérdida de habilidades mediante la interpretación automatizada de electrocardiogramas o imágenes radiológicas. Sin embargo, un estudio observacional publicado a principios de este año acentua esta preocupación, sugiriendo que colonoscopistas experimentados perdieron cierta eficacia en la detección de pólipos de colon cuando se desactivó el soporte rutinario de IA.

En cuatro centros de endoscopia polacos, 19 gastroenterólogos y cirujanos que utilizaron un sistema de detección de pólipos con IA durante 3 meses mostraron un descenso en las tasas de detección de adenomas al realizar colonoscopias sin IA posteriormente. Como grupo, su rendimiento de detección de pólipos tras la IA quedó por debajo de su propio rendimiento base previo a la IA. Algunos endoscopistas experimentaron caídas dramáticas, mientras que otros mantuvieron su rendimiento. Este hallazgo sugiere que la descalificación no es inevitable y que debemos buscar enfoques para mitigar la descalificación médica a medida que la IA se integra en la atención rutinaria. Podemos aprender de otras industrias que durante mucho tiempo han lidiado con equilibrar la automatización y la retención de habilidades.

En aviación, los sistemas de piloto automático han aportado mejoras en seguridad, pero también han suscitado preocupaciones sobre la erosión de las habilidades de vuelo manual. Los reguladores respondieron exigiendo tiempo de vuelo práctico rutinario y sesiones en simulador que imitaran fallos del sistema.

Los operadores de centrales nucleares ensayan escenarios críticos a intervalos regulares para asegurarse de que, si la automatización falla, las habilidades esenciales permanezcan intactas.

El potencial para la deshabilitación relacionada con la IA va mucho más allá de la endoscopia gastrointestinal. Las especialidades quirúrgicas e intervencionistas requieren vigilancia constante y preparación para responder a eventos inesperados. La dermatología, la patología y la radiología exigen un análisis visual meticuloso y el reconocimiento de patrones. Más allá de los procedimientos o la interpretación de imágenes, el razonamiento clínico para el diagnóstico, la toma de decisiones y la gestión del paciente requiere un pensamiento crítico que podría verse erosionado por las interacciones de la IA. Los encuentros con los pacientes suelen ser apresurados, dejando poco espacio para un análisis y razonamiento más profundos. No es de extrañar, entonces, que los médicos acogieran con agrado la promesa de la IA para compartir la carga. Pero cuando la IA se consolida en la práctica clínica, surgen nuevos riesgos. La vigilancia puede disminuir, las habilidades podrían deteriorarse, y cuanto más dependan los médicos de la IA, menos confianza tendremos en nuestro propio juicio sin ayuda. Estas preocupaciones son especialmente relevantes durante la formación médica, donde los médicos en formación pueden depender de la IA antes de desarrollar plenamente competencias básicas (nunca capacitarse), dejando poca base en la que recurrir si la tecnología falla y limitando las experiencias formativas que permiten desarrollarse plenamente la intuición y el juicio clínicos. Proteger las habilidades médicas y el pensamiento crítico en un entorno habilitado por IA no tendrá una solución única y sencilla. La trayectoria de la descalificación, la sobredependencia o la pérdida de vigilancia variará según los algoritmos, especialidades y contextos, al igual que las posibles soluciones. Una salvaguarda podría ser incluir intervalos cortos y deliberados de «apagado o retraso de IA» en los flujos de trabajo clínicos, para recalibrar la vigilancia y capturar medidas objetivas del rendimiento sin asistencias. Durante las sesiones de entrenamiento o mantenimiento de habilidades, las interpretaciones de la IA podrían configurarse para aparecer solo después de que el lector registre sus propios hallazgos. Otro enfoque es trazar límites más firmes: la IA asume trabajos basados en reglas, de alto volumen y baja ambigüedad, liberando a los médicos para que se centren más en decisiones contextuales, ambiguas y de alto riesgo. Por ejemplo, en radiología, un algoritmo de IA podría excluir de forma segura radiografías normales de tórax para que los radiólogos puedan concentrarse en hallazgos sutiles o complejos. Estos límites ayudarían a reducir el sesgo de automatización (confiar demasiado en los resultados incorrectos de la IA) y el abandono automatizado (ignorar los correctos), que pueden surgir cuando supuestamente se comparten las tareas. Sea cual sea la estrategia, la base debe ser la capacidad continua de los clínicos para evaluar la fiabilidad de cualquier herramienta de IA. El estudio de descalificación de la IA por colonoscopia no es una acusación contra la IA.

La evidencia de más de 40 ensayos aleatorizados para la detección de pólipos de IA muestra que ayuda a los médicos a detectar más pólipos precancerosos de colon. Debemos acoger con satisfacción tales avances, pero mantenernos atentos a cómo cambiarán el comportamiento y la atención clínica de los médicos a medida que la IA se integre en la práctica.

La adopción de la IA se está acelerando, pero los flujos de trabajo y hábitos están abiertos a ser moldeados. Las decisiones que tomemos ahora sobre cómo diseñamos, integramos y formamos en torno a la IA determinarán si estos sistemas elevan nuestra profesión o erosionan silenciosamente las habilidades que la definen.