Arch Pathol Lab Med (2017) 141 (5): 704–717.

https://doi.org/10.5858/arpa.2016-0348-HP

Donde comenzó la historia de la acreditación y la calidad.

Contexto.

El primer proyecto importante del Colegio Americano de Cirujanos (Chicago, Illinois), fundado en 1913, fue la implementación de las Normas Mínimas para Hospitales. La norma de 1918 (1) estableció organizaciones de personal médico en los hospitales; (2) restringió la membresía a profesionales con licencia y en regla; (3) ordenó que el personal médico trabajara con la administración del hospital para desarrollar y adoptar regulaciones y políticas que regulen su trabajo profesional; (4) exigió registros médicos estandarizados y accesibles; y (5) exigió la disponibilidad de instalaciones de diagnóstico y terapéuticas. Hace cien años, estas eran expectativas radicales.

Las condiciones de la práctica quirúrgica y de los servicios hospitalarios en Norteamérica a principios del siglo XX eran pésimas. 1 Sin embargo, se estaban poniendo en marcha los mecanismos para solucionarlo. Había un gran exceso de profesionales médicos y muchos de ellos estaban mal formados. Además, la distinción entre la práctica médica y la práctica quirúrgica aún no estaba formalizada, por lo que algunos de estos médicos incompetentes también practicaban la cirugía. A principios del siglo XX, los médicos mejor formados comenzaron a agruparse y a formar organizaciones especializadas. La afiliación dependía de demostrar un nivel mínimo adecuado de competencia. Los especialistas asumieron naturalmente que los pacientes que necesitaran tratamiento médico o quirúrgico acudirían en masa a los miembros de estos gremios de élite, lo que beneficiaría tanto a los pacientes como a los intereses económicos de los profesionales. 2 , 3 El Colegio Americano de Cirujanos (ACS, Chicago, Illinois) se creó en 1913, con planes audaces para estandarizar no sólo a los cirujanos sino también el lugar de trabajo de los cirujanos: el hospital. 4 , 5 Un año antes de la formación de la ACS, se formaron 2 comités en el Congreso Clínico de Cirujanos de Norteamérica (CCSNA) de 1912: (1) presidido por el cirujano ginecológico de Chicago, Illinois, Franklin H. Martin, MD ( Figura 1 ), debía supervisar los acuerdos para establecer la ACS; y (2) presidido por el cirujano de Boston Ernest Amory Codman, MD (

Figura 2 ), debía supervisar la reforma hospitalaria. 5 Reconociendo que ni la CCSNA ni la ACS tendrían un mandato legal para reformar los hospitales, las reformas tendrían que llevarse a cabo con gran diplomacia, con esfuerzos para no alienar a otros médicos o a la Asociación Médica Estadounidense (AMA, Chicago, Illinois) y requerirían la participación voluntaria de los hospitales. Desafortunadamente, la diplomacia nunca había sido el punto fuerte del Dr. Codman.

Junta de regentes del Colegio Americano de Cirujanos de 1919. Franklin H. Martin, MD, está a la extrema derecha; John G. Bowman, MA, LittD es el segundo desde la extrema derecha; Charles H. Mayo, MD es el cuarto desde la extrema izquierda; George W. Crile, MD es el sexto desde la extrema izquierda. Crédito: Archivos del Colegio Americano de Cirujanos .

Fotografía de Ernest Amory Codman realizada por el Notman Studio de Boston (circa 1911). Crédito: Se trata de una reproducción que se conserva en la Biblioteca Médica de Boston, en la Biblioteca de Medicina Francis A. Countway (Boston, Massachusetts) .

El Dr. Codman estaba fascinado por los estudios de tiempo-movimiento, la eficiencia, la gestión científica de la industria ferroviaria y el movimiento de estandarización que caracterizó la revolución industrial estadounidense de mediados y fines del siglo XIX. Cuando trabajaba como cirujano asistente en el Hospital General de Massachusetts (Boston, Massachusetts) en 1900, desarrolló un interés especial en la eficiencia y la estandarización hospitalaria, y esos intereses pronto se convirtieron en su pasión de toda la vida. 6 , 7 El Dr. Codman desarrolló e impulsó incansablemente un visionario «sistema de resultados finales» de organización hospitalaria, que explicó en sus términos más simples de la siguiente manera 8 (p. 315) :

Este sistema es perfectamente simple, y su única dificultad es su revolucionaria simplicidad. Requiere respuestas directas y veraces a estas preguntas: ¿Qué le pasaba al paciente? ¿Qué le hizo el médico? ¿Cuál fue el resultado? Si el resultado no fue bueno, ¿cuál fue la razón? ¿Fue culpa del médico, del paciente, de la enfermedad o de la organización o el equipo del hospital? Hasta ahora, en la organización hospitalaria nunca se ha intentado sistemáticamente determinar quién es el responsable del éxito o el fracaso de cada caso tratado. Sostengo que nuestro sistema de registros debería permitirnos determinar quién es el responsable y que debería utilizarse para este fin.

El Dr. Codman apoyó la idea de mantener registros hospitalarios detallados con resultados (basados en el seguimiento 1 año después del alta) para cada admisión, generando puntajes de resultados para hospitales y para médicos para cada tipo de enfermedad o procedimiento, permitiendo a los médicos realizar solo procedimientos quirúrgicos para los cuales tuvieron puntajes de resultados suficientemente altos, promoción de cirujanos basados en sus puntajes de resultados en lugar de antigüedad o popularidad y, lo que es importante, supervisión del programa de resultados finales de cada hospital por parte de los fideicomisarios del hospital, que creía que deberían aceptar la responsabilidad de «la calidad del Producto que sus fábricas hospitalarias dan al Público». 9 (p76) El Dr. Codman fue inflexible en que los resultados de los hospitales y cirujanos individuales deberían publicarse porque eso permitiría a los pacientes potenciales tomar decisiones informadas relacionadas con la atención quirúrgica y hospitalaria futura. El Dr. Codman se sintió tan convencido de sus ideas que renunció al personal del Hospital General de Massachusetts, comenzó su propio pequeño hospital en el que implementó su sistema completo a pequeña escala y luego publicó sus resultados. 10 El Dr. Codman, que en otro tiempo había caído en el olvido, ha sido redescubierto en las últimas décadas y mucho se ha escrito recientemente sobre él 6 – 8 , 11 , 12 ; por lo tanto, este ensayo no se centrará en él, sino más bien en un movimiento que él ayudó a iniciar. Aunque el modelo completo del Dr. Codman resultó ser demasiado radical para ser implementado en la década de 1910, o incluso hoy, 12 el Dr. Codman es ahora reconocido correctamente como un pionero de la “investigación de resultados”, y él y su modelo tuvieron papeles importantes en la formulación del programa de estandarización hospitalaria de la ACS. Debido a que el Dr. Codman era impetuoso, franco y carecía de tacto y diplomacia, no pudo ver personalmente cómo este programa se concretaba, y algunos de los elementos más controvertidos que más apreciaba fueron abandonados. Dos años después de la formación de la ACS, uno de los trucos publicitarios del Dr. Codman, que avergonzó al Hospital General de Massachusetts, a sus cirujanos y a la Universidad de Harvard (Boston, Massachusetts), lo obligó a renunciar a la presidencia del comité de reforma hospitalaria del CCSNA. 5 Nahrwold y Kernahan 5 (pág. 33) resumieron los logros del Dr. Codman de la siguiente manera:

Defendió con fuerza, aunque no siempre con tacto, su «sistema de resultados finales»… Desafortunadamente, Codman carecía de las habilidades ejecutivas de Franklin Martin. Su comité elaboró dos informes que confirmaban la necesidad de mejorar el hospital, pero dejaban cualquier acción en manos de la AMA o la Fundación Carnegie. La AMA no tenía ningún interés en asumir un proyecto que pudiera conducir a un conflicto con los miembros locales. Los intentos de Codman de interesar a la Fundación Carnegie en una encuesta sobre hospitales no tuvieron éxito….. Con sus propios problemas políticos en aumento, Codman renunció al comité a fines de 1915. Con eso, el comité de la CCSNA se disolvió y el Colegio asumió la tarea de estandarizar los hospitales.

El resto de este ensayo se centrará en el desarrollo y la implementación del programa de estandarización hospitalaria de la ACS; es un tema que, sorprendentemente, se ha abordado, en el mejor de los casos, superficialmente en el contexto del Dr. Codman y la eficiencia hospitalaria, 13-15 o se ha abordado de manera fragmentada 2 , 9 en fuentes estándar que tratan de la historia de los hospitales estadounidenses. De hecho, una fuente afirma directamente en una nota a pie de página que «no hay un trabajo adecuado sobre el movimiento de estandarización…» 14 (p148, nota a pie de página 34). Sin embargo, los lectores deben saber, aunque no es una historia per se, que hay un artículo fascinante que sostiene que la estandarización hospitalaria estaba «estrechamente vinculada» al movimiento filosófico pragmático estadounidense, que comenzó a fines del siglo XIX y que «representa un hito importante en la historia de la regulación estadounidense, tal vez el primer sistema de autorregulación empapado en principios pragmáticos de ordenamiento social, un modelo de gobernanza de la era progresista que presagió durante mucho tiempo algunas de las innovaciones regulatorias más significativas de la actualidad». 16 (p9) Sin embargo, independientemente de sus orígenes filosóficos, el programa de estandarización hospitalaria de la ACS fue un marco regulatorio importante para los hospitales durante 32 años antes de evolucionar hacia la Comisión Conjunta de Acreditación de Hospitales en 1951, que pasó a llamarse Comisión Conjunta de Acreditación de Organizaciones de Atención Médica en 1987 y Comisión Conjunta (Oakbrook Terrace, Illinois) en 2007. 17 Hacia el final de este artículo, analizaré cómo los Estándares Mínimos para hospitales afectaron a los laboratorios hospitalarios, una perspectiva que, hasta donde yo sé, no se ha abordado en la limitada literatura sobre estandarización hospitalaria.

FORMACIÓN DE LA ACS Y SUS ESTÁNDARES MÍNIMOS PARA HOSPITALES

La primera reunión de la ACS se celebró en Washington, DC, la tarde del lunes 5 de mayo de 1913. Asistieron 450 cirujanos estadounidenses y canadienses, tanto generalistas como especialistas. Esta reunión fue planificada por un comité organizador de 12 cirujanos destacados designados por la CCSNA en su reunión de noviembre de 1912. Los miembros del Comité Organizador de la CCSNA recorrieron los Estados Unidos y Canadá a través de una serie de reuniones regionales. Esencialmente, en «cada gran ciudad universitaria», se organizó una reunión por 3 cirujanos locales y 1 de los 12 miembros del comité organizador. De estas reuniones regionales, se invitó a 500 cirujanos, asistieron 450 y nació la ACS. 4 , 5 La ACS tenía objetivos elevados de mejorar la calidad de la atención a los pacientes quirúrgicos elevando la formación y la práctica quirúrgicas.

En 1914, la dirección de la ACS, mientras todavía “perfeccionaba la organización de la Facultad y… obtenía una base financiera sólida”, 18(p114) determinó que la estandarización hospitalaria era su primera gran iniciativa y, por lo tanto, “comenzó a adquirir información de primera mano sobre las condiciones hospitalarias en Canadá y los Estados Unidos. Se reunió con médicos, fideicomisarios y superintendentes de hospitales sobre el trabajo; con sociedades médicas y con organizaciones hospitalarias, pidiendo su ayuda y cooperación para formular un plan de acción”. 18(p114) Aunque no está claro que esta estandarización hospitalaria comenzara como una iniciativa educativa, rápidamente adquirió ese tono porque esto ayudó a justificar por qué la estandarización hospitalaria estaba claramente dentro del mandato de la facultad. Había razones potenciales por las que la estandarización hospitalaria, si era supervisada por la ACS, podría beneficiar financieramente a los miembros de la ACS (nb, según el sociólogo Paul Starr, controlar el lugar de trabajo del hospital era un objetivo a largo plazo de los gremios de médicos para que pudieran “evitar el destino del trabajador asalariado sin herramientas”). 15(p165) El 22 de junio de 1914, los becarios aprobaron un plan para recaudar un fondo de dotación permanente y acordaron que los ingresos de ese fondo se utilizarían para promover los propósitos de la ACS. Tras bambalinas, varios cirujanos destacados de la ACS, como George W. Crile, MD ( Figura 1 ) (presidente de cirugía en el University Hospitals Case Medical Center [Cleveland, Ohio] y, pronto, cofundador de la Cleveland Clinic [Cleveland, Ohio]), Charles H. Mayo, MD ( Figura 1 ), y William J. Mayo, MD (es decir, los hermanos Mayo que transformaron el St. Mary’s Hospital en la Mayo Clinic [Rochester, Minnesota]), inicialmente no apoyaron porque crearía una carga financiera significativa para la universidad, 5 lo que precipitó conversaciones infructuosas con la AMA pidiéndoles que asumieran este papel en su lugar. 2 En febrero de 1915, John G. Bowman, MA, LittD ( Figura 1 ), presidente de la Universidad de Iowa (Iowa City, Iowa) y ex secretario de la Fundación Carnegie para el Avance de la Enseñanza (Stanford, California), fue nombrado director de educación de la ACS. 5 El Dr. Martin continuó como el poderoso secretario de la universidad.

Para el 1 de diciembre de 1915, el Dr. Martin ya había recaudado $526 000 de los aproximadamente 3400 cirujanos miembros. 19 En enero de 1916, la ACS anunció oficialmente que tenía un fondo de dotación de $500 000. Ese mismo anuncio decía: “[d]en la medida en que la capacitación adecuada en cirugía está inseparablemente relacionada con la conducta y eficiencia del hospital, el Colegio buscará datos precisos sobre todos los asuntos relacionados con los hospitales”. 20 (pp116–117) Para fines de mes, los Dres. Martin y Bowman, confiando en las conexiones personales de este último, también habían recaudado $30 000 adicionales de la Fundación Carnegie, específicamente para la estandarización del hospital. 2 , 5

En la reunión anual de becarios celebrada en Filadelfia (Pensilvania) el 27 de octubre de 1916, el informe del director Bowman 21 proporcionó una orientación aún más clara. El discurso del Dr. Bowman se centró en sólo dos temas: la admisión a la beca y la investigación de las condiciones hospitalarias. Como esta última era una nueva orientación pública y él necesitaba “educar” a los becarios, eso comprendió la mayor parte de su charla. El Dr. Bowman justificó la nueva orientación enteramente dentro del contexto de la educación quirúrgica 21 (p. 745) :

Este trabajo no es simplemente algo que podemos hacer, es algo que debemos hacer. Es nuestro deber saber qué significa la verdadera formación en cirugía. Eso ha sido obvio para todos nosotros desde el principio. Y es una estimación acertada, creo, decir que el ochenta por ciento de lo que un cirujano utiliza en la práctica lo adquiere durante su internado [ sic ] y su formación hospitalaria. En otras palabras, el campo de formación particular para el cirujano es el hospital. Se nos impone, entonces, la obligación de saber cuál es este campo de formación y qué tipo de estándar debemos establecer como formación adecuada de un cirujano en un hospital. Además, el problema de la formación de un cirujano en un hospital no puede aislarse como un factor separado del programa del hospital… Sin embargo, existen divisiones específicas en cada hospital que podemos investigar y, si tenemos datos precisos, podemos señalar el camino del progreso.

El Dr. Bowman abordó luego una serie de temas específicos, entre ellos la conservación de los registros hospitalarios (¿están completos los registros de casos y son “accesibles para su estudio y orientación futura?”), el estado de los servicios de laboratorio, la relación del personal médico del hospital con el consejo de administración del hospital y el superintendente del hospital, la acreditación del hospital, la relación del hospital con la sociedad médica local o del condado y la relación del hospital con el público. En relación con esto último, el Dr. Bowman tuvo palabras contundentes 21 (p. 746) :

¿Por qué los administradores no deberían poder garantizar honestamente a sus comunidades servicios honestos y competentes? Tal es una de las cosas que el Colegio Americano de Cirujanos se propone lograr. Se propone abordar estos problemas de una manera que no sea incierta ni a medias. La parte central de su esfuerzo será una serie de folletos escritos de manera tan sencilla que el hombre que mueve los labios al leer pueda entenderlos. Estos folletos tratarán uno tras otro de las cosas que hacen que los hospitales sean el tipo adecuado de instituciones para el cuidado de los enfermos. A veces puede ser necesario convocar reuniones de los clubes comerciales locales, o de otros organismos de laicos, para concienciar a la comunidad sobre las condiciones reales de sus hospitales. Si este camino es necesario, se seguirá. Ya pasó el día en que cualquier tipo de práctica indiferente o incompetente se podía proteger en un hospital. Ya pasó el día en que los administradores de los hospitales podían descansar en una actitud irresponsable hacia la confianza depositada en ellos.

Aunque ahora estaba plenamente integrado en el mandato educativo de la universidad, lo que en realidad se estaba proponiendo podría haber sido fácilmente interpretado por personas ajenas a la institución como una guerra abierta contra el status quo de la atención hospitalaria en Norteamérica, e incluso la poderosa AMA, aunque reconocía plenamente la necesidad de una reforma hospitalaria, no estaba dispuesta a hacerse cargo de este problema, una decisión de la que la AMA se arrepentiría más tarde. 1 , 4 , 5 Cada área de la reforma contenía minas terrestres potenciales para una o más partes interesadas. Por ejemplo, en el ámbito de la conservación de registros médicos, ni siquiera estaba del todo claro si los hospitales tenían el derecho. Según la historiadora médica y socióloga Rosemary A. Stevens, PhD 9 (pág. 60) :

Un médico que admitiera a sus propios pacientes no tenía incentivos para crear registros que otros pudieran usar o que sirvieran al hospital en su conjunto… Los médicos podían afirmar que eran dueños de sus propios registros y que el hospital, como taller del médico, no tenía un interés legítimo separado en registrar o monitorear la atención del paciente.

Intuitivamente, el riesgo asociado con una única especialidad médica, incluso una poderosa, que abordara la reforma hospitalaria era alto. Después de todo, la ACS representaba sólo a unos pocos médicos norteamericanos (en el mejor de los casos, alrededor del 5%). Por otra parte, la mayoría de los pacientes hospitalarios eran pacientes quirúrgicos, y el número de hospitales había aumentado exponencialmente en cuestión de sólo unas décadas 1 ; por lo tanto, los hospitales no podían darse el lujo de alienar a los cirujanos. Aunque la presencia de su fondo de dotación posicionó a la universidad para actuar rápidamente, era evidente que era necesario que la ACS actuara con cuidado, lo que logró mediante el uso de un proceso abierto y consultivo, que, lo que es importante, incluyó a otras especialidades médicas.

También en la reunión anual de 1916 en Filadelfia, Pensilvania, “se pidió a los becarios que crearan en cada provincia de Canadá y en cada estado de la Unión un comité de normas, cuyo propósito era asesorar sobre un programa de acción sólido y constructivo”. 18 (p. 114) De acuerdo con esa votación, se crearon dichos comités de normas en toda América del Norte, pero los comités no pudieron reunirse para una reunión de grupo hasta el 19 y 20 de octubre de 1917, debido a la Primera Guerra Mundial. 19 En esa reunión de dos días en Chicago, Illinois, aproximadamente 330 miembros del comité y entre 50 y 60 superintendentes de hospitales líderes de toda América del Norte discutieron “tres preguntas fundamentales”: “¿Qué condiciones existen en los hospitales? ¿Qué queremos en los hospitales y [qué] se debe hacer?” 18 (p. 114) Según la universidad 18 (p. 114) :

El resultado inmediato de la reunión fue el nombramiento de un comité de veintiún miembros, en el que estaban representados médicos, cirujanos, administradores de hospitales, trabajadores de laboratorio, estadísticos, etc., con el propósito de esbozar un cuestionario a través del cual el Colegio pudiera obtener datos hospitalarios esenciales para su trabajo futuro y considerar un “estándar mínimo de eficiencia”. El comité de veintiún miembros se reunió durante dos días en Washington, en diciembre de 1917, formuló el cuestionario y discutió el “estándar mínimo”. A principios de 1918, el cuestionario se envió a los hospitales, junto con una carta solicitando la cooperación de los hospitales en el programa de estandarización. La respuesta de los hospitales a este cuestionario superó las esperanzas más optimistas de los interesados en el trabajo. Llegaron cientos de cartas de todas partes del continente, prometiendo cooperación. … En marzo de 1918, se envió a los hospitales y a los becarios una declaración completa del programa de estandarización hospitalaria del Colegio y del estándar mínimo. En marzo de 1918 se emprendió la labor de realizar investigaciones personales en los hospitales. El Colegio contrató a visitadores o inspectores para que hicieran informes sobre las condiciones de los distintos hospitales. Una parte importante de la labor de los visitadores consistía también en explicar los detalles del programa de una forma más completa que la que se puede hacer con folletos o cartas, y dejar claro el espíritu de toda la iniciativa.

Aunque un proceso rápido y contundente como el que se propone podría resultar intimidante, la brillante forma en que la ACS promocionó todo el proceso básicamente lo impidió. La universidad definió la estandarización hospitalaria de la siguiente manera 18 (pág. 113) :

No se trata de hacer que los hospitales sean iguales en cuanto a su forma de gobierno, administración o equipamiento; no se busca imponer la conformidad con ningún molde determinado ni limitar la originalidad en ninguna fase del trabajo hospitalario. La estandarización hospitalaria implica que los médicos, los administradores y superintendentes del hospital, los trabajadores de laboratorio, las enfermeras y el público piensen de la misma manera sobre los objetivos y la utilidad de los hospitales. Significa que cada paciente de un hospital tiene derecho a la atención más eficiente que conozca la profesión médica…

Definida por tales declaraciones de “maternalidad”, ¿cómo podría cualquier persona u organización razonable adoptar una postura pública en contra de cooperar para lograr una mejor atención al paciente? Este sentimiento también estaba en consonancia con el movimiento progresista estadounidense y, cada vez más, todos los proveedores de atención médica reconocieron que los hospitales, que a fines del siglo XIX existían como “hoteles” para pacientes pobres y principalmente para la comodidad de médicos y cirujanos, ahora debían centrarse en la calidad de la atención al paciente y la experiencia del paciente. 16 Los hospitales incluso reconocieron que la reforma era necesaria desde una perspectiva comercial porque la reputación de los hospitales en los Estados Unidos había sido tan pésima durante todo el siglo XIX que los pacientes ricos los habían evitado y, en cambio, generalmente eran atendidos en sus hogares.

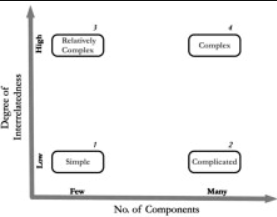

La facultad consideró cómo abordar esta cuestión, señalando que “hay dos métodos por los cuales la estandarización hospitalaria puede proceder. El primero es científico; el segundo, humano”. 18 (p113) La descripción de la facultad del “método científico” puede parafrasearse en el lenguaje actual como de arriba hacia abajo , usando la fuerza bruta para implementar su propio análisis. Un ejemplo contemporáneo de este tipo de enfoque de estandarización del que la dirección de la ACS habría sido extremadamente consciente fue el Informe Flexner de 1910 , también financiado por la Fundación Carnegie, que impulsó una escuela de medicina estandarizada con requisitos académicos mínimos para la admisión y un plan de estudios basado en los principios de la “medicina científica” utilizando un entorno de hospital docente. 22 Claramente, la dinámica era completamente diferente (nb, había demasiadas escuelas de medicina privadas y uno de los objetivos de Abraham Flexner, MD, OD, PhD, era sacar del negocio a las escuelas de medicina sin esperanza; en marcado contraste, no había un número excesivo de hospitales, y la ACS simplemente quería mejorarlos). Hay otra razón, aún más fundamental, por la que semejante enfoque no habría funcionado. Los dirigentes de la ACS, aunque reconocían que la estandarización hospitalaria era deseable y que ellos debían liderarla, no tenían una idea clara de cómo querían que fuera y, como la participación sería voluntaria, no tenían idea de qué sería aceptable para las diversas partes interesadas. Además, los dirigentes de la ACS reconocieron que cualquier modelo que se implementara debía cambiar y mejorar constantemente. 16 La complejidad de esos objetivos debe haber parecido obvia al Dr. Bowman, que era el director de educación de la ACS y ni siquiera era médico. Así que, en cambio, la universidad adoptó sabiamente el enfoque del “método humano”, como se describe a continuación 18 (pág. 113) :

El método humano nunca olvida el punto de vista de los demás. De hecho, es el único punto de vista que conoce. Supone que los hombres son inteligentes y de mente abierta. Pero no es sentimental ni se limita a “azúcar, especias y todo lo bueno”. Valora el pensamiento recto y los datos precisos tanto como el método científico. Según el método humano, la estandarización hospitalaria dice a los hospitales: “He aquí un plan para mejorar el servicio hospitalario. Es un plan que surgió de nuestras propias cabezas y corazones después de un esfuerzo concienzudo y prolongado por parte de todos nosotros para idear dicho plan. ¿Podrían considerar si lo aceptan o no?”

El enfoque altamente consultivo de la universidad era laborioso y costoso. Después de enviar por correo la Norma Mínima (Figura 3) a los 697 hospitales de los Estados Unidos y Canadá con 100 o más camas, en marzo de 1918, 7 miembros del personal de la universidad, llamados visitantes , se dividieron la tarea de visitar personalmente cada hospital. Los visitantes simplemente presentaron la norma y explicaron lo que significaba 23 (pp469,473) :

El Colegio no se atribuyó la autoridad de hacer cumplir la norma. En todo momento, el Colegio dependió del mérito y la solidez de sus propuestas para conseguir y mantener la cooperación de los interesados en la obra… Estos hombres, todos ellos licenciados en medicina, fueron a los hospitales… como ingenieros, descubriendo primero cuáles eran las deficiencias de la institución en relación con la norma mínima y luego indicando cómo se podían superar mejor. Las reuniones de consejo celebradas en los distintos hospitales por estos inspectores resultaron ser un elemento importante para el éxito de la obra.

Estos visitantes recogieron datos, que se cotejaron en la sede de la universidad, para cada hospital utilizando “tarjetas de visita” estandarizadas 23 ( Figura 4 ). El enfoque de la visita personal funcionó y los hospitales cooperaron y se esforzaron por alcanzar el estándar. La dirección de la ACS puede haber adaptado este método de visita personal del que habían utilizado con éxito para reunir rápidamente a los cirujanos en 1912-1913 para formar la ACS.

Figura 3.

El documento de Normas mínimas se creó en algún momento entre el 8 y el 9 de diciembre de 1917 y el 1 de marzo de 1918, cuando se envió por correo a los becarios y a los hospitales. Se utilizó como el estándar de oro para los datos recopilados durante las visitas a los sitios a partir de 1918. Crédito: Archivos del Colegio Estadounidense de Cirujanos .

Certificado mural de estándares mínimos del Colegio Estadounidense de Cirujanos que se otorga a los hospitales que cumplen con el estándar. Crédito: Archivos del Colegio Estadounidense de Cirujanos .

Durante los primeros años del programa de estandarización hospitalaria de la ACS, el Dr. Bowman era el director y el Dr. Martin era el secretario de la ACS, un puesto a tiempo parcial. En 1917, los regentes designaron al Dr. Martin para un puesto a tiempo completo, el de secretario general, lo que creó una falta de claridad en relación con la gobernanza de la ACS y, en 1920, el Dr. Bowman estaba considerando sus otras opciones. En noviembre de 1920, el Dr. Bowman aceptó el puesto de rector de la Universidad de Pittsburgh (Pittsburgh, Pensilvania). Después de un breve reemplazo interino, los puestos se consolidaron y el Dr. Martin se convirtió en el director general. Después de la renuncia del Dr. Bowman, la ACS contrató a Malcolm MacEachern, MD, CM, 29 cirujano con sede en Vancouver, Columbia Británica y superintendente del Hospital General de Vancouver (Vancouver, Columbia Británica, Canadá), para dirigir el programa de estandarización hospitalaria de la ACS, que manejó de manera excelente durante los siguientes 27 años. 5

En la década de 1920, el director general de la ACS, el Dr. Martin, curiosamente invocó la capacidad de la universidad para “reescribir” la historia y, sin dejar de atribuirse el mérito, desvinculó a la universidad de haber iniciado unilateralmente el proceso de estandarización hospitalaria. Según el Dr. Martin, hablando en 1921 27 (p133) :

El Colegio Americano de Cirujanos es responsable de la estandarización de los hospitales, porque en sus inicios consideró necesario estandarizar sus propios entornos. Por ejemplo, al elaborar un estándar para la admisión a la beca, fue necesario que pidiéramos a los candidatos que nos proporcionaran los informes de cincuenta operaciones mayores y cincuenta operaciones menores, en lugar de un examen. Estos informes comenzaron a llegar. Estaban en todo tipo de formularios. No existía absolutamente ningún registro estándar en el que pudieran darnos la evidencia de su propia capacidad para ejercer la cirugía. Pronto nos pidieron desde todas las direcciones que proporcionáramos un sistema estandarizado de registros, que sugiriéramos un formato en el que estos registros pudieran entregarse al Colegio. Intentamos hacerlo. Se formó un comité para ese propósito, y proporcionamos, donde se requirió, un conjunto de registros estandarizados. ¿Y luego qué sucedió? Los hospitales -una gran cantidad de ellos- comenzaron a preguntarnos si no podíamos de alguna manera proporcionarles esos mismos registros o formularios estandarizados, lo cual, por supuesto, hicimos con mucho gusto. Ese fue el primer paso en la estandarización de los hospitales.

Aunque mantener registros adecuados se convirtió claramente en un interés común compartido por la ACS y los hospitales, es difícil concebir cómo podría ser ese el “primer paso” en el movimiento de estandarización hospitalaria porque esto comenzó con el Dr. Codman y su comité CCSNA, incluso antes de que se formara la ACS. De todos modos, los registros se convirtieron en un terreno común tanto para la ACS como para los hospitales, y la ACS tenía razón al señalar que “un hospital en el que un candidato a becario prepara estos registros, si no mantiene registros adecuados, generalmente se ve inducido a hacerlo”. 18 (p. 116)

Los estándares mínimos eran exactamente eso, requisitos rudimentarios para un hospital adecuado. El primer componente del estándar era el personal médico organizado ( Figura 3 ), que era fundamental. Debido a que los planificadores de la ACS no sabían exactamente cómo debería ser un hospital estandarizado, la expectativa era que, una vez que se cumplieran los Estándares Mínimos , el personal médico organizado asumiría un sentido activo de responsabilidad personal que facilitaría la mejora continua en todas las áreas en cada hospital estandarizado, 16 que era el plan maestro de la ACS para el futuro, y tenía la ventaja adicional de garantizar que los médicos controlarían su lugar de trabajo, a través de los auspicios de la ACS.

La AMA había considerado emprender la reforma hospitalaria tanto en 1913 como en 1914 y había contactado sin éxito a la Fundación Carnegie para obtener fondos de subvención para llevarlo a cabo. Incluso la dirección de la ACS, que estaba preocupada por las finanzas de su incipiente gremio, había tratado de convencer a la Junta de Síndicos de la AMA para que asumiera esa función en 1914, pero la “AMA se negó sobre la base de los gastos”. 2(p91) El Dr. Stevens concluyó que “la relativa pobreza del Colegio en 1914… sugería a la AMA que no había una gran competencia para sus propias actividades en la estandarización hospitalaria. Pero como resultado, la AMA perdió la iniciativa en el movimiento de estandarización hospitalaria. El Colegio Americano de Cirujanos se convirtió en la fuerza dominante detrás de la reforma hospitalaria”. 2 (p119) En 1917, la dirección de la AMA reconoció que habían cometido un grave error táctico y que habían sido superados por la ACS, que había contratado al ex secretario de la Fundación Carnegie para que fuera su director. En 1918, el poderoso Consejo de Educación Médica de la AMA anunció que ampliaría su mandato para incluir la estandarización hospitalaria y en junio de 1920 pasó a llamarse Consejo de Educación Médica y Hospitales, pero la AMA ya había perdido la batalla por el control del lugar de trabajo de los médicos. Después de eso, como señaló el Dr. Stevens, «en muchas áreas… la Facultad se había convertido en una fuerte fuerza competitiva potencial». 2(p125) A partir de entonces, la relación entre estas dos poderosas organizaciones se volvió cada vez más tensa.